正式入職小米還不到10天,羅福莉的首篇論文,這就來(lái)了!

在這篇出自MiMo團(tuán)隊(duì)(主打空間智能)的研究中,羅福莉作為團(tuán)隊(duì)負(fù)責(zé)人擔(dān)任核心作者,小米智駕團(tuán)隊(duì)首席科學(xué)家陳龍則作為項(xiàng)目負(fù)責(zé)人。

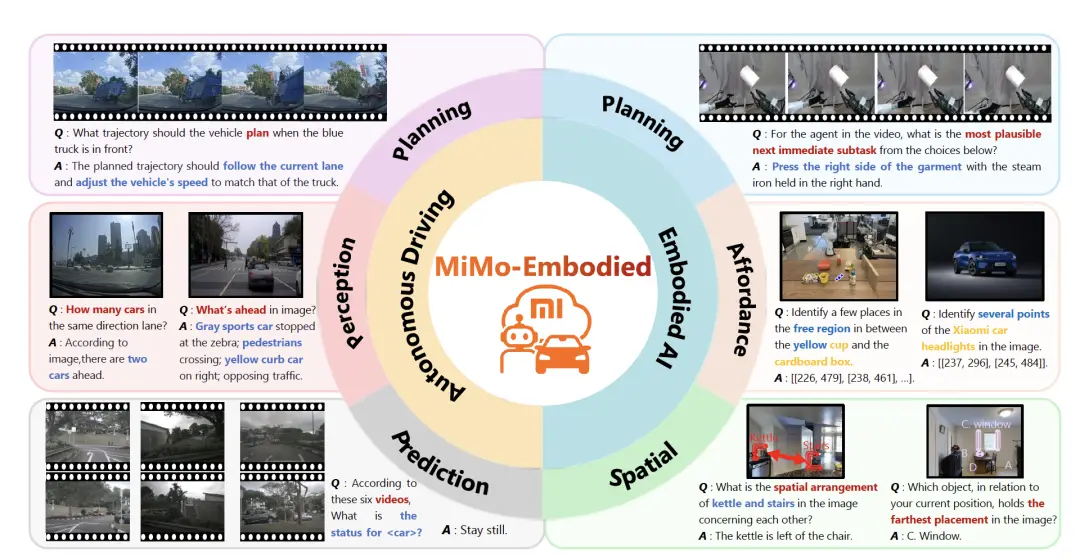

而這項(xiàng)研究最亮眼的地方,恰恰是具身智能與自動(dòng)駕駛的跨界融合。

針對(duì)自駕與具身操作場(chǎng)景的知識(shí)遷移難題,MiMo團(tuán)隊(duì)提出并開源了全球首個(gè)打通這兩大領(lǐng)域的跨具身(X - Embodied)基座模型——MiMo-Embodied。

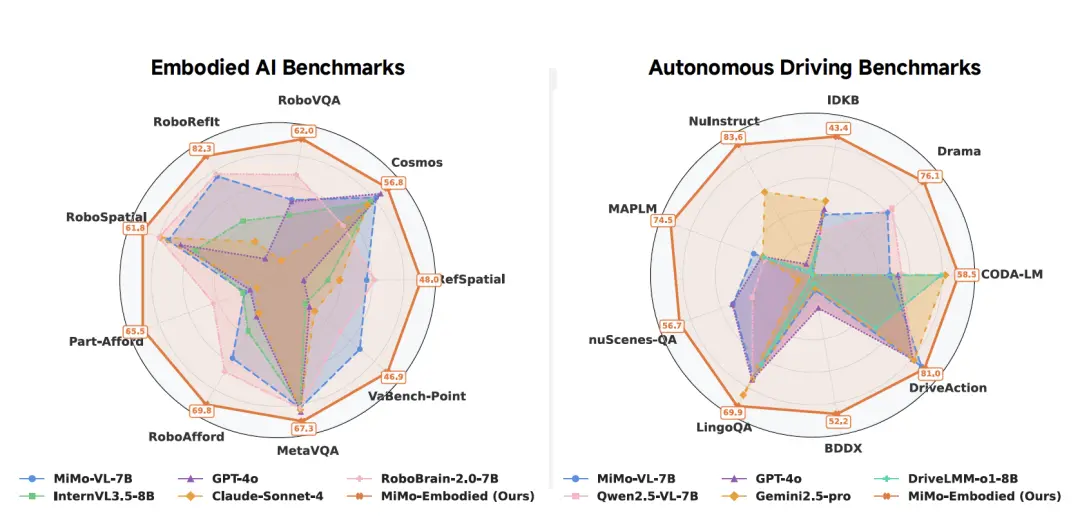

在實(shí)測(cè)效果上,MiMo-Embodied在自動(dòng)駕駛與具身智能共計(jì)29個(gè)Benchmark上全部霸榜!

無(wú)論是開車的環(huán)境感知、規(guī)劃,還是機(jī)器人的拿取、導(dǎo)航,主打一個(gè)我全都要。

具身與智駕,小米全都要!

如上所說(shuō),小米這次開源的MiMo-Embodied是業(yè)界首個(gè)開源的、成功融合了自動(dòng)駕駛與具身智能(Embodied AI)兩大領(lǐng)域的統(tǒng)一多模態(tài)基礎(chǔ)模型。

它基于MiMo-VL架構(gòu),通過(guò)構(gòu)建涵蓋通用視覺(jué)、具身任務(wù)及駕駛場(chǎng)景的高質(zhì)量數(shù)據(jù)集,并采用包含思維鏈(CoT)和強(qiáng)化學(xué)習(xí)(RL)的漸進(jìn)式四階段訓(xùn)練策略,有效打破了室內(nèi)操作與戶外駕駛之間的領(lǐng)域鴻溝。

最終,該模型在任務(wù)規(guī)劃、空間理解、環(huán)境感知及駕駛規(guī)劃等29個(gè)基準(zhǔn)測(cè)試中,均超越了現(xiàn)有的專用模型及通用模型,實(shí)現(xiàn)了跨領(lǐng)域的最先進(jìn)(SOTA)性能。

接下來(lái),我們具體來(lái)看。

在以往具身/自駕的VLM領(lǐng)域中,往往存在以下問(wèn)題:

一方面是缺乏統(tǒng)一的具身VLM(Unified Embodied VLM)。

現(xiàn)有的視覺(jué)語(yǔ)言模型(VLMs)大多專注于單一領(lǐng)域(僅室內(nèi)任務(wù)或僅戶外駕駛),缺乏能夠連接這兩個(gè)領(lǐng)域的統(tǒng)一模型。限制了模型在動(dòng)態(tài)環(huán)境中與物理世界有效交互的能力。

而這,也帶來(lái)了領(lǐng)域差距與遷移困難。

具身智能側(cè)重于室內(nèi)操作,而自動(dòng)駕駛側(cè)重于戶外道路,兩者存在顯著的領(lǐng)域差距(Domain Gap),阻礙了能力的跨領(lǐng)域遷移 。

另一方面則是評(píng)估體系缺失, 即缺乏全面的跨具身能力評(píng)估體系來(lái)衡量模型在兩個(gè)領(lǐng)域的綜合表現(xiàn)。

為了解決這些挑戰(zhàn), MiMo-Embodied試圖將自動(dòng)駕駛和具身智能的任務(wù)合并到一個(gè)統(tǒng)一的VLM中,以整合模型的跨具身能力。

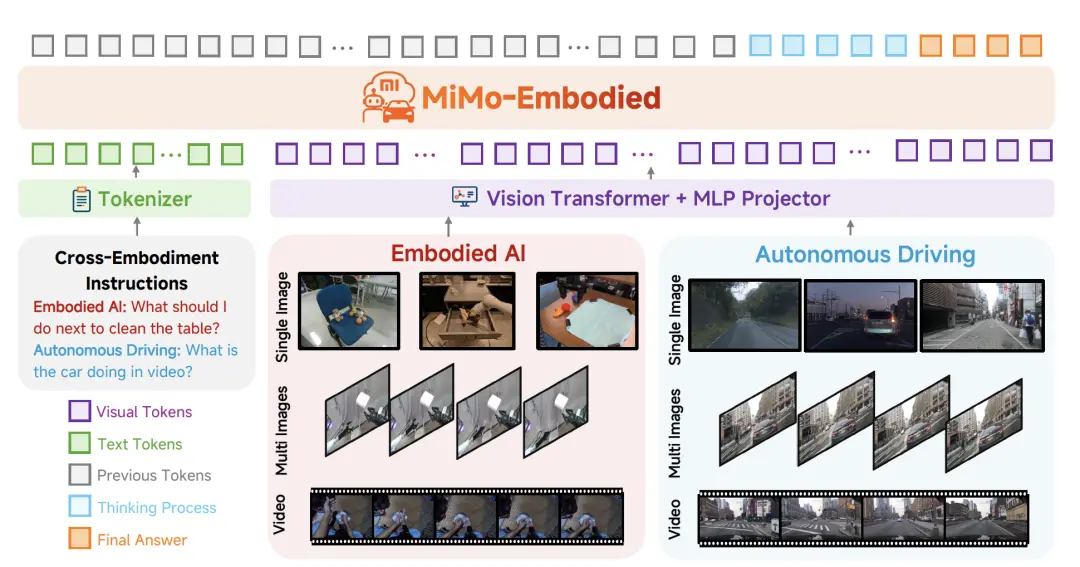

如上圖所示,MiMo-Embodied架構(gòu)由以下三個(gè)部分組成:

用于編碼視覺(jué)輸入的 Vision Transformer (ViT):模型使用ViT來(lái)編碼各種類型的視覺(jué)輸入,包括單張圖像、多張圖像和視頻。這使得模型能夠提取復(fù)雜的模式和關(guān)系。

一個(gè)投影器(projector): 使用多層感知機(jī)(MLP)作為投影器(Projector),將視覺(jué)Token映射到與大語(yǔ)言模型對(duì)齊的潛在空間。

負(fù)責(zé)文本理解和推理的LLM:LLM作為核心組件,負(fù)責(zé)理解文本指令并結(jié)合視覺(jué)信息進(jìn)行推理,生成連貫且上下文相關(guān)的響應(yīng)。

由此,通過(guò)無(wú)縫集成視覺(jué)和文本領(lǐng)域,MiMo-Embodied增強(qiáng)了多樣化多模態(tài)推理任務(wù)和應(yīng)用的潛力。

接下來(lái),為了實(shí)現(xiàn)跨領(lǐng)域的統(tǒng)一能力,論文提出了一套系統(tǒng)的數(shù)據(jù)構(gòu)建和分階段訓(xùn)練策略:

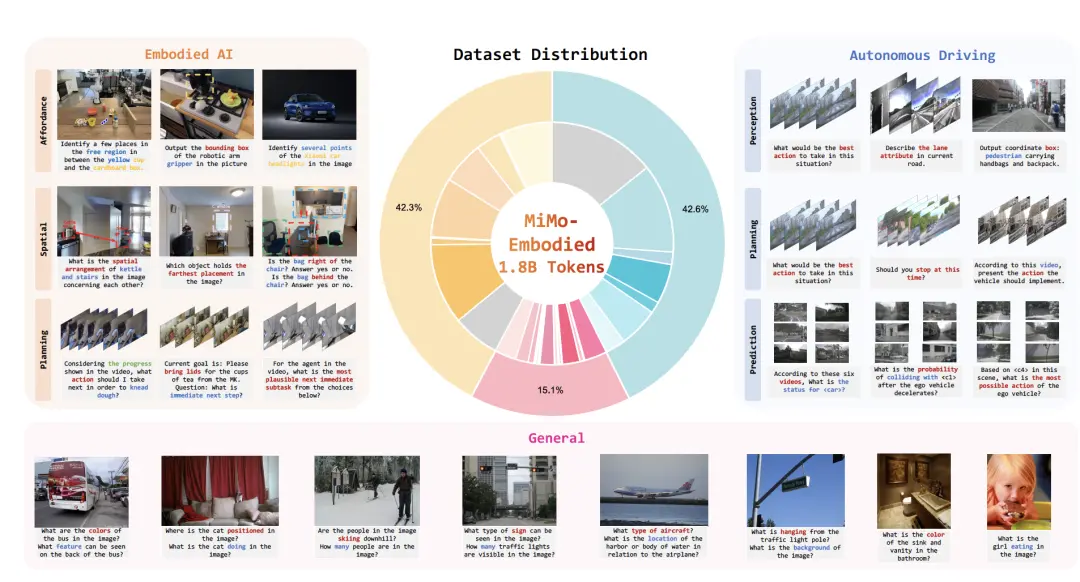

首先在數(shù)據(jù)方面,訓(xùn)練數(shù)據(jù)涵蓋了通用多模態(tài)理解、具身 AI(功能性預(yù)測(cè)、規(guī)劃、空間理解)和自動(dòng)駕駛(感知、預(yù)測(cè)、規(guī)劃)三個(gè)維度的多模態(tài)數(shù)據(jù):

通用數(shù)據(jù): 基于MiMo-VL語(yǔ)料庫(kù),包含圖像、視頻、長(zhǎng)文本等,長(zhǎng)文檔和合成推理數(shù)據(jù),確保廣泛覆蓋感知、推理和交互能力。

具身智能數(shù)據(jù): 涵蓋可供性預(yù)測(cè)(Affordance Prediction)、高層任務(wù)規(guī)劃和空間理解,整合了如 PixMo-Points, RoboAfford, RoboRefIt等數(shù)據(jù)集。

自動(dòng)駕駛數(shù)據(jù): 涵蓋環(huán)境感知、狀態(tài)預(yù)測(cè)和駕駛規(guī)劃,整合了 CODA-LM, DriveLM, nuScenes-QA等數(shù)據(jù)集。

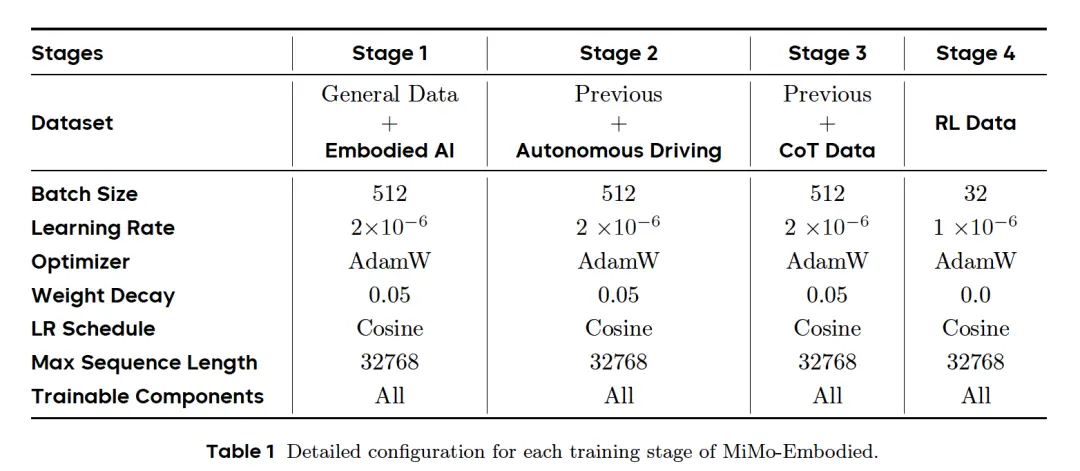

基于上述構(gòu)建的數(shù)據(jù)集,研究又開發(fā)了一種四階段訓(xùn)練策略。

基于MiMo-VL,研究引入了具身智能和自動(dòng)駕駛方面的專門監(jiān)督,最終通過(guò)思維鏈微調(diào)和強(qiáng)化學(xué)習(xí)實(shí)現(xiàn)高級(jí)推理能力 。

這一策略有助于模型建立在先前獲得的能力之上,從而在具身交互和自動(dòng)駕駛領(lǐng)域?qū)崿F(xiàn)穩(wěn)健的性能。

階段1:具身智能監(jiān)督微調(diào) (Embodied AI Supervised Fine-tuning):結(jié)合通用數(shù)據(jù)和具身數(shù)據(jù),建立核心的視覺(jué)語(yǔ)言理解、具身推理能力。

階段2:自動(dòng)駕駛監(jiān)督微調(diào) (Autonomous Driving Supervised Fine-tuning): 在階段1的基礎(chǔ)上,加入大量自動(dòng)駕駛數(shù)據(jù)。重點(diǎn)訓(xùn)練多視角空間推理、視頻時(shí)間一致性和復(fù)雜交通場(chǎng)景分析 。

階段3:思維鏈推理微調(diào) (CoT Supervised Fine-tuning): 使用包含明確推理步驟的數(shù)據(jù)進(jìn)行微調(diào)。這增強(qiáng)了模型處理復(fù)雜多步問(wèn)題的能力,例如風(fēng)險(xiǎn)評(píng)估和行為合理性解釋。

階段4:強(qiáng)化學(xué)習(xí)微調(diào) (RL Fine-Tuning): 使用 GRPO (Group Relative Policy Optimization) 算法。通過(guò)針對(duì)正確性(如選擇題匹配、IoU計(jì)算)設(shè)計(jì)獎(jiǎng)勵(lì)信號(hào),進(jìn)一步優(yōu)化模型的精確度和可靠性。

實(shí)驗(yàn)測(cè)試

為了驗(yàn)證MiMo-Embodied的性能,研究分別在定性和定量?jī)蓪用孢M(jìn)行評(píng)估,定量比較涉及針對(duì)具身智能和自動(dòng)駕駛的各種既定學(xué)術(shù)和行業(yè)基準(zhǔn)的客觀評(píng)估,從而能夠與領(lǐng)先模型進(jìn)行直接的實(shí)證比較。

定性評(píng)估則展示了MiMo-Embodied在現(xiàn)實(shí)世界任務(wù)中的實(shí)際效能,突出了其在復(fù)雜機(jī)器人和自動(dòng)駕駛場(chǎng)景中的部署,并提供了其將習(xí)得能力轉(zhuǎn)化為有效性能的具體證據(jù) 。

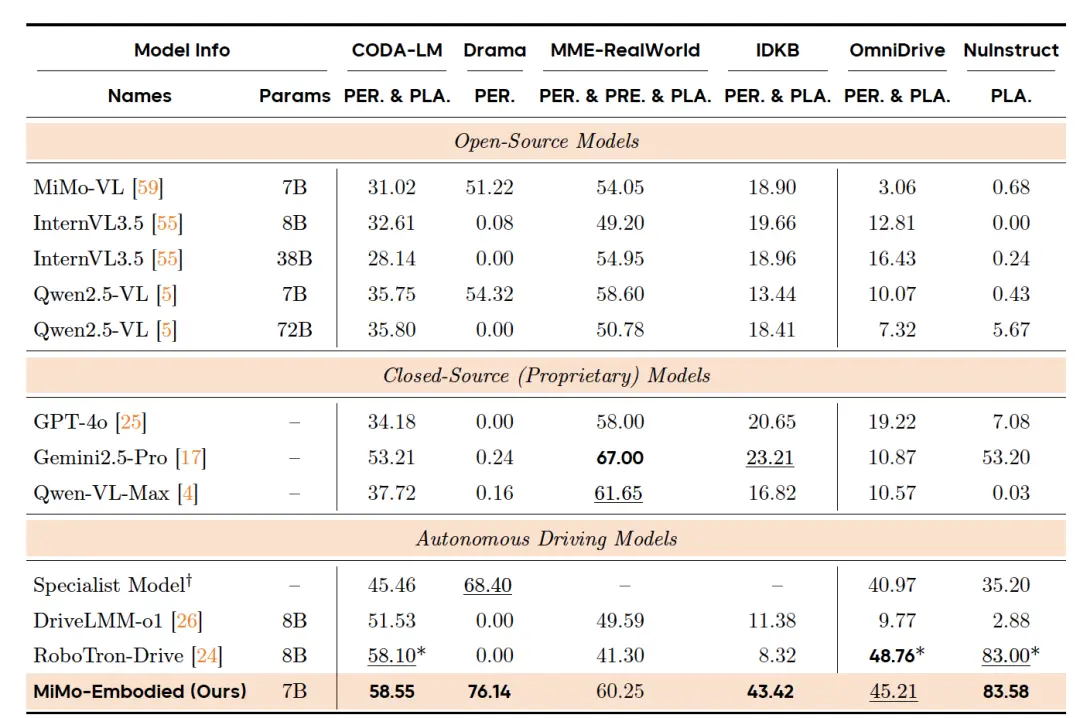

基準(zhǔn)測(cè)試上的定量比較

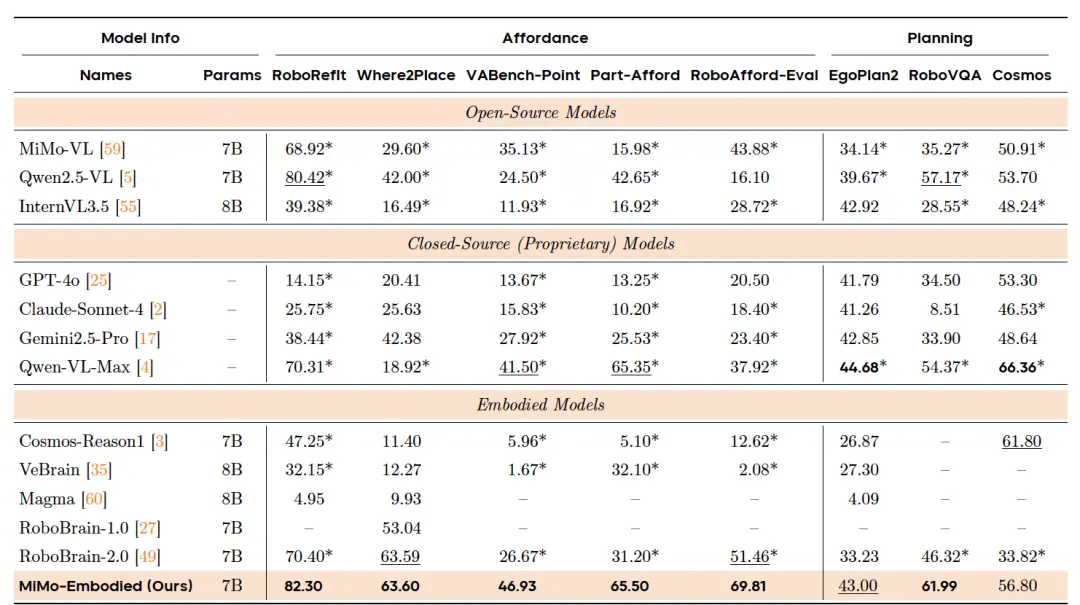

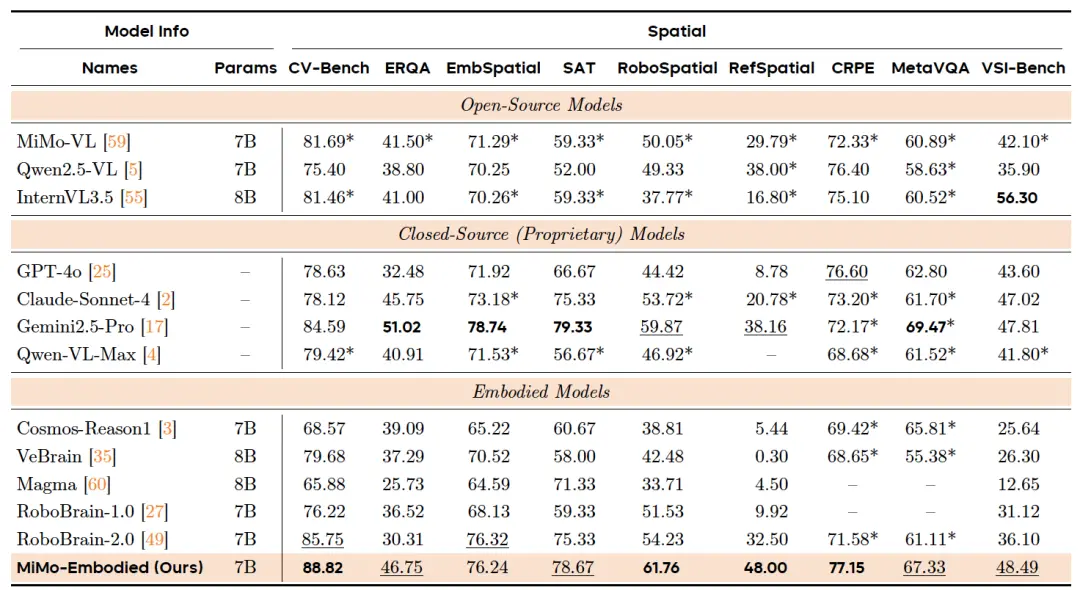

首先,在具身能力方面,研究在三個(gè)核心領(lǐng)域進(jìn)行了全面評(píng)估:可供性預(yù)測(cè)、任務(wù)規(guī)劃和空間理解。

結(jié)果表明,MiMo-Embodied 取得了具有競(jìng)爭(zhēng)力的結(jié)果,與通用多模態(tài)模型和專用具身模型相比,在可供性預(yù)測(cè)和空間理解方面表現(xiàn)出特別的優(yōu)勢(shì)。

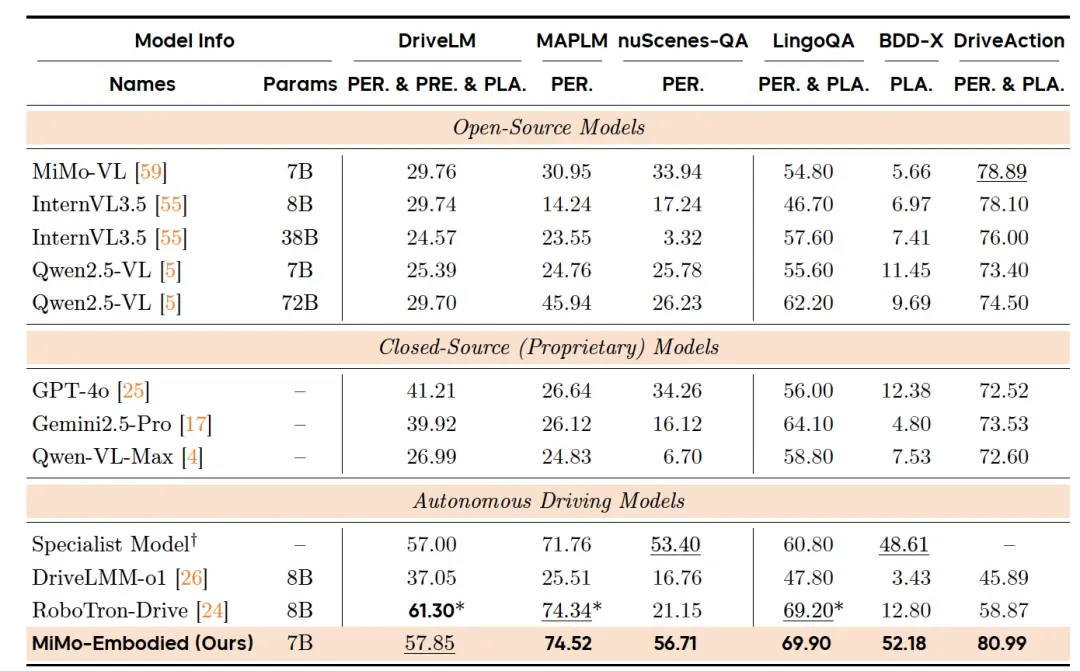

其次,在自動(dòng)駕駛能力方面,研究在感知能力、預(yù)測(cè)能力和規(guī)劃能力上進(jìn)行了評(píng)估。包含在4種數(shù)據(jù)類型上的12個(gè)基準(zhǔn)測(cè)試中的性能,涉及其理解復(fù)雜交通場(chǎng)景、預(yù)測(cè)動(dòng)態(tài)道路智能體行為以及生成安全高效駕駛建議的能力。

實(shí)驗(yàn)結(jié)果顯示,MiMo-Embodied在所有感知基準(zhǔn)測(cè)試、預(yù)測(cè)、規(guī)劃中均取得了強(qiáng)勁的性能,在全景語(yǔ)義理解任務(wù)中展示了最先進(jìn)的結(jié)果,同時(shí)在具有挑戰(zhàn)性的局部感知場(chǎng)景中也表現(xiàn)出卓越的魯棒性。

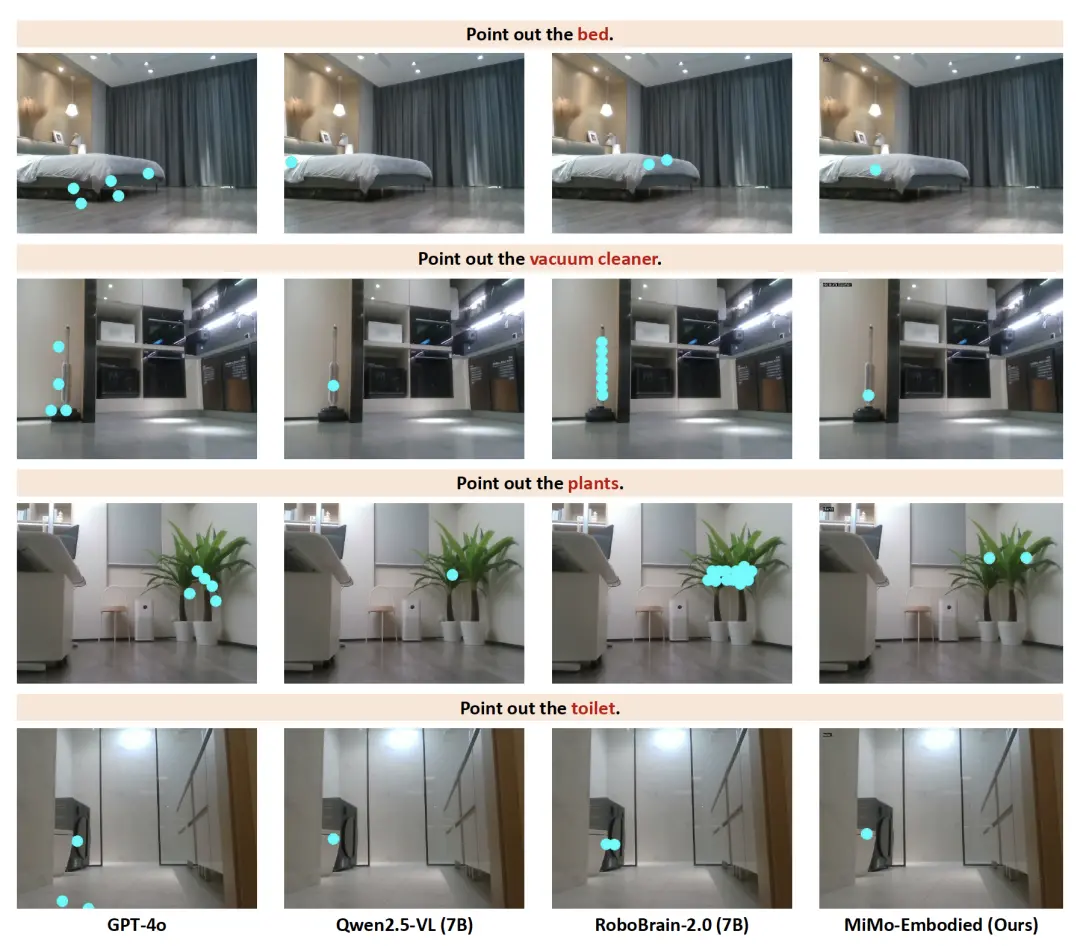

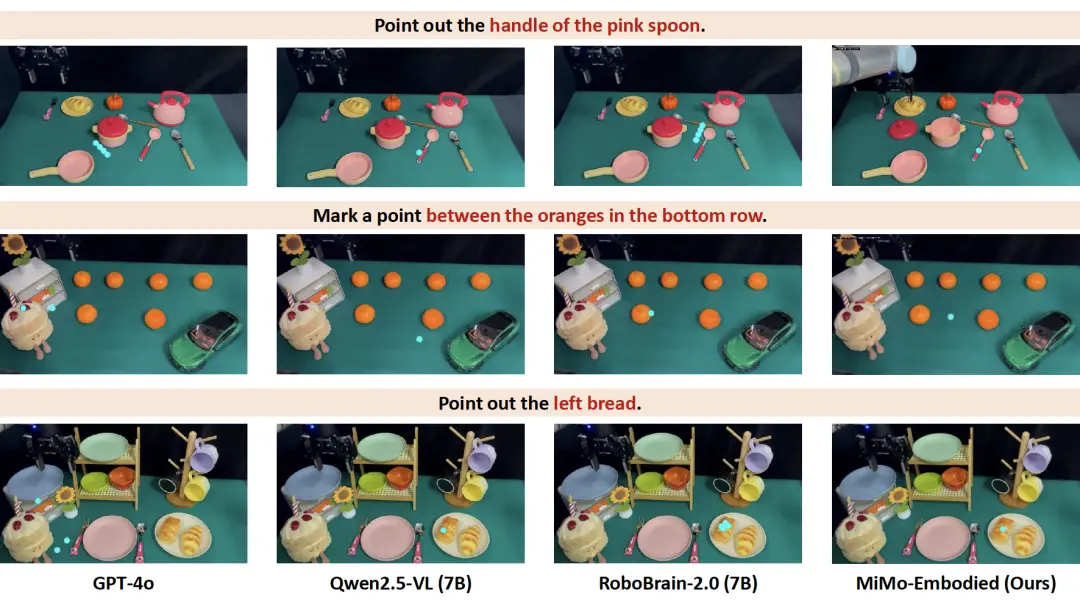

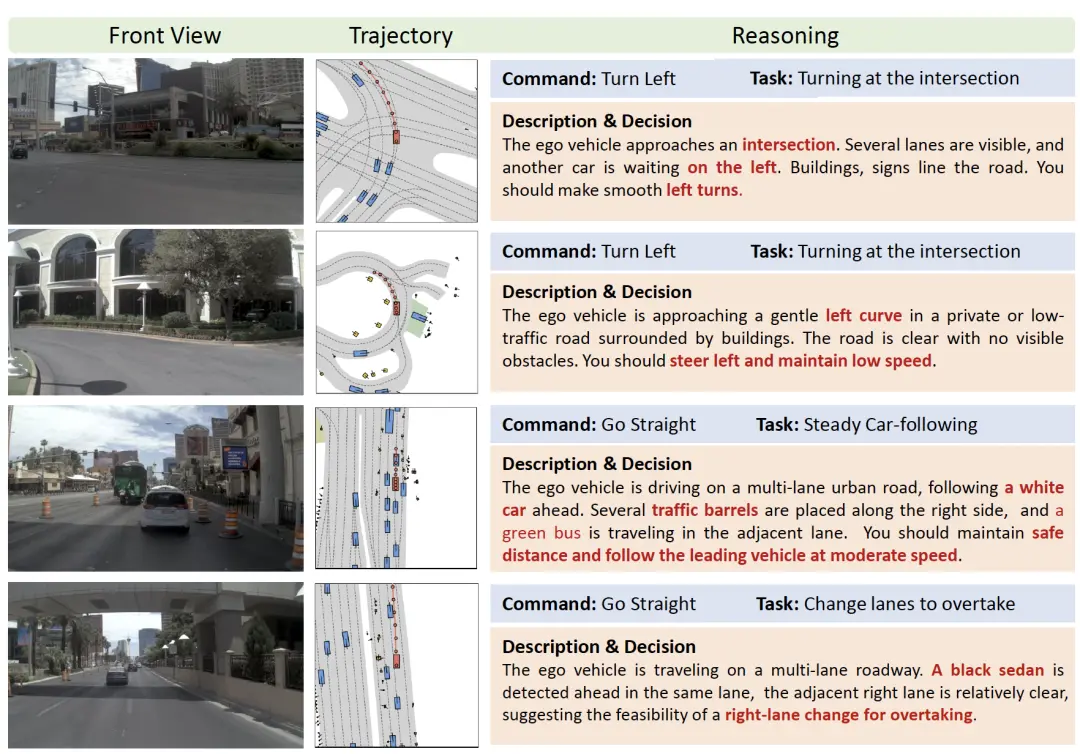

現(xiàn)實(shí)世界任務(wù)的定性評(píng)估

首先,為了驗(yàn)證MiMo-Embodied 在復(fù)雜交互環(huán)境中的實(shí)際效用,研究評(píng)估了其在兩個(gè)基本下游應(yīng)用中的性能:具身導(dǎo)航和操作。

在具身導(dǎo)航中,相較于GPT-4o、Qwen2.5-VL和RoboBrain-2.0,MiMo-Embodied展現(xiàn)出在多樣化家庭場(chǎng)景中增強(qiáng)的對(duì)象定位能力和一致的性能。

在操作任務(wù)中,MiMo-Embodied同樣展現(xiàn)出強(qiáng)大的可供性和空間推理能力。

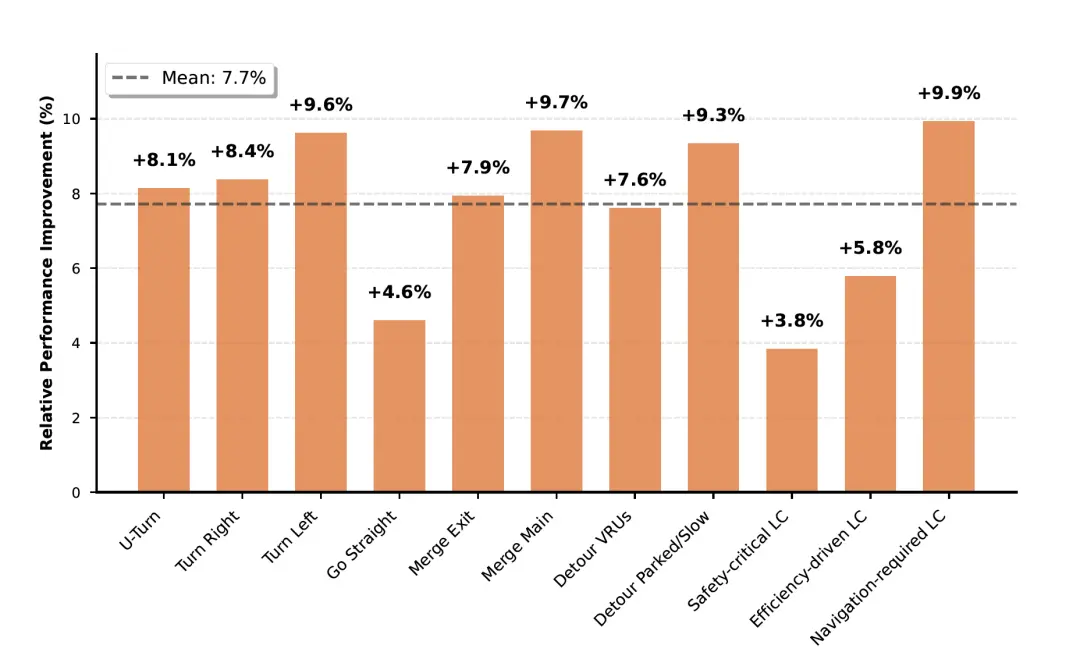

在自動(dòng)駕駛能力上,研究首先在NAVSIM上確定性能以進(jìn)行標(biāo)準(zhǔn)化比較,然后在一個(gè)包含多樣化真實(shí)世界駕駛場(chǎng)景的大規(guī)模專有數(shù)據(jù)集上測(cè)試模型的能力。

實(shí)驗(yàn)結(jié)果表明MiMo-Embodied可以處理多樣化的自動(dòng)駕駛情況并完成具有挑戰(zhàn)性的任務(wù),包括交叉路口轉(zhuǎn)彎、彎道掉頭、跟車和變道超車。

在每種情況下,模型都應(yīng)感知道路上下文,整合自車狀態(tài)和導(dǎo)航意圖,并做出連貫的決策。

此外,MiMo-Embodied在所有評(píng)估類別中始終優(yōu)于基線。值得注意的是,在轉(zhuǎn)彎、繞開障礙物和變道等復(fù)雜、交互式操作中,性能提升最為顯著。

在最后,論文表示還將基于MiMo-Embodied模型的能力,探索具身智能視覺(jué)-語(yǔ)言-動(dòng)作(VLA)模型,以增強(qiáng)復(fù)雜環(huán)境中的交互,通過(guò)自然語(yǔ)言理解實(shí)現(xiàn)更直觀的任務(wù)執(zhí)行。

One more thing

這篇論文,是羅福莉于11月12日正式官宣加盟小米、出任MiMo團(tuán)隊(duì)負(fù)責(zé)人后,發(fā)布的第一篇論文。

作為業(yè)界備受關(guān)注的95后AI才女,她本科畢業(yè)于北京師范大學(xué),碩士在北京大學(xué)繼續(xù)深耕。

碩士畢業(yè)后,她加入阿里巴巴達(dá)摩院擔(dān)任機(jī)器智能實(shí)驗(yàn)室研究員,主導(dǎo)開發(fā)多語(yǔ)言預(yù)訓(xùn)練模型 VECO,并推動(dòng)核心項(xiàng)目AliceMind的開源落地。

2022 年,羅福莉加入DeepSeek母公司幻方量化,后續(xù)任職DeepSeek深度學(xué)習(xí)研究員,深度參與 DeepSeek-V2等標(biāo)桿模型的研發(fā)工作。

而本論文的Project Leader(項(xiàng)目負(fù)責(zé)人)陳龍,也于今年正式入職小米,擔(dān)任智能駕駛首席科學(xué)家。

在此之前,陳龍?jiān)温氂谟?guó)AI獨(dú)角獸公司Wayve,主導(dǎo)新一代端到端自動(dòng)駕駛VLA模型的研發(fā)。

更早前,他還以研究工程師身份加入Lyft,牽頭車隊(duì)學(xué)習(xí)項(xiàng)目,通過(guò)大規(guī)模眾包車隊(duì)數(shù)據(jù)完成自動(dòng)駕駛車輛機(jī)器學(xué)習(xí)規(guī)劃器的預(yù)訓(xùn)練。